Check_MK Agent über SSH Verbindung

Wenn man das Check_MK Monitoring nicht über den Standardport (xinet) laufen lassen möchte / kann besteht dich Möglichkeit dies über eine SSH Verbindung zu realisieren. Hierfür muss nur einiges an Vorarbeit erledigt werden.

Auf jedem Host der zu monitoren ist legt man einen User für den Check_Mk Agents an.

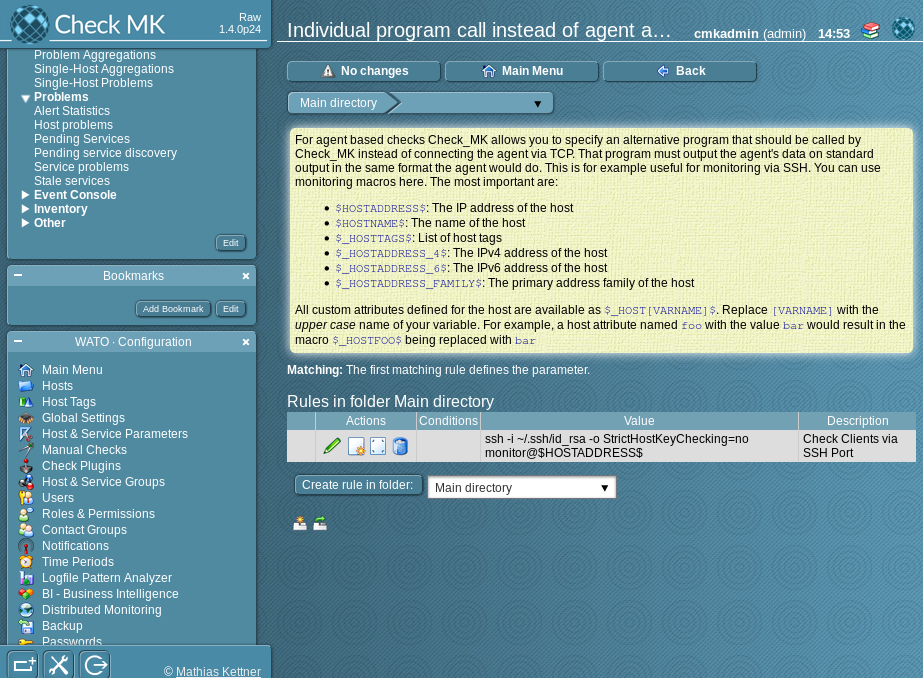

Ist das der Fall muss jetzt noch in der WATO eine Regel erstellt werden.

Unter Host & Service Parameters→Datasource Programs→Individual program call instead of agent access eine Regel für die Umgebung erstellen

Mehr Info : Check_MK - Anleitung zu diesem Thema

Auf jedem Host der zu monitoren ist legt man einen User für den Check_Mk Agents an.

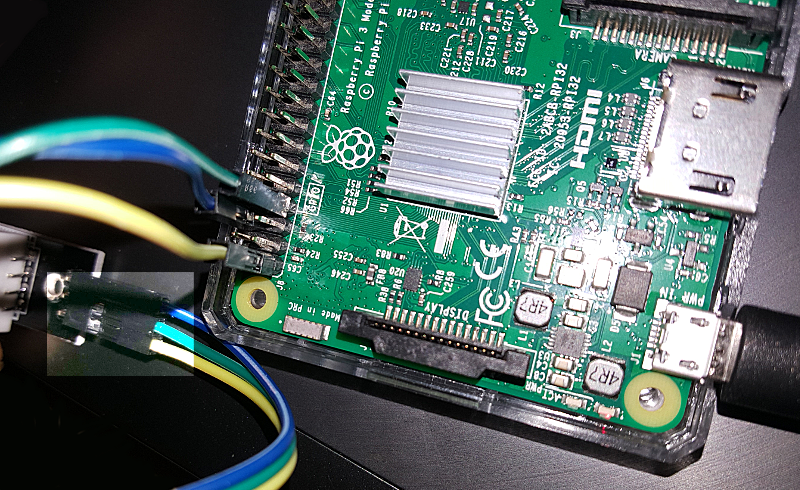

useradd -d /home/monitor -c 'CHECK_MK User' -g monitor -m -s /bin/bash monitorAuf dem Monitoring-Server einen SSH Key für das monitoring erstellen. Dazu logt ihr euch über ssh auf dem Server ein und wechselt mit su - sitename auf die Check_MK Site (User). Dort legt ihr ein SSH-Keypair an.

ssh-keygen -t monitordann zeigt ihr euch den schlüssel über cat an und pflegt diesen auf den zu monitorenden Hostsystemen unter dem User monitor ein ( /home/monitor/.ssh/authorized_keys )

cat ~/.ssh/id_monitor.pubEintrag auf den Hostsystemen :

command="sudo /usr/bin/check_mk_agent" ssh-rsa [SSH KEY DES SERVERS]Jetzt muss noch die sudoers Config angepasst werden.

vi /etc/sudoersDort fügt man die folgenden Zeilen ein, trägt man den User monitor ein

# Allow User monitor to run check_mk_agent monitor ALL=NOPASSWD: /usr/bin/check_mk_agentJetzt kann man das bis jetzt mal testen.Wenn ihr euch über ssh auf dem Host als User monitor anmeldet, oder den check_mk_agent lokal auf dem Host als User monitor ausführt, muss der selbe output zu sehen sein.

Ist das der Fall muss jetzt noch in der WATO eine Regel erstellt werden.

Unter Host & Service Parameters→Datasource Programs→Individual program call instead of agent access eine Regel für die Umgebung erstellen

ssh -i ~/.ssh/id_rsa -o StrictHostKeyChecking=no monitor@$HOSTADDRESS$dann sollten nach einem TabulaRasa alle Services zu sehen sein.

check_mk_agent über ssh

Mehr Info : Check_MK - Anleitung zu diesem Thema