ntop : Eigene Anwendung zu Port zuordnen

Erstmal was ist ntop eigentlich.

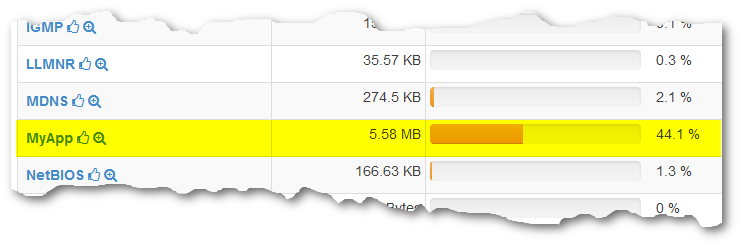

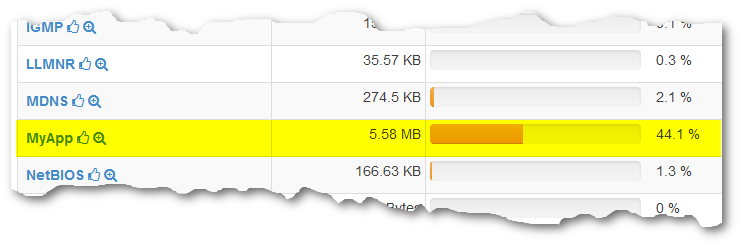

Diese Software kann schön genutzt werden um z.B. auf einem Gateway oder einer Firewall zu monitoren wo der Traffic so hin läuft. Es werden schon ein ganzer Pack Plugins mitgeliefert aber eigene Anwendungen werden nicht erkannt. Ich habe hier eine kleine Anwendung geschrieben die über udp Port 5404 Daten versendet. Jetzt möchte ich natürlich das auch in meinem Gateway angezeigt bekommen um zu beurteilen wieviel Traffic darüber läuft. Das kann man relativ einfach realisieren jedoch hat es mir auch etwas Arbeit gekostet diesen einfachen Weg zu finden

Erstellt eine Datei in der später die Protokolle hinzugefügt werden.

Mehr Infos :

http://www.ntop.org/ndpi/configuring-ndpi-for-custom-protocol-detection/

ntop (network top) ist eine quelloffene und freie Software, mit der Netzwerkverkehr mitgeschnitten und analysiert werden kann.Quelle : https://de.wikipedia.org/wiki/Ntop

Diese Software kann schön genutzt werden um z.B. auf einem Gateway oder einer Firewall zu monitoren wo der Traffic so hin läuft. Es werden schon ein ganzer Pack Plugins mitgeliefert aber eigene Anwendungen werden nicht erkannt. Ich habe hier eine kleine Anwendung geschrieben die über udp Port 5404 Daten versendet. Jetzt möchte ich natürlich das auch in meinem Gateway angezeigt bekommen um zu beurteilen wieviel Traffic darüber läuft. Das kann man relativ einfach realisieren jedoch hat es mir auch etwas Arbeit gekostet diesen einfachen Weg zu finden

Erstellt eine Datei in der später die Protokolle hinzugefügt werden.

touch /usr/share/ntopng/httpdocs/protocol-app.txtJetzt füge ich meine Anwendung hinzu, das diese auch im Webfrontend nicht mehr unter UNKNOWN läuft.

echo "udp:5404 @MyApp" > /usr/share/ntopng/httpdocs/protocol-app.txtdann müssen wir noch dafür sorgen das diese Datei auch beim Start von ntopng gelesen wird dazu editieren wir das configfile unter /etc/ntopng mit dem Befehl.

echo "-p /usr/share/ntopng/httpdocs/protocol-app.txt" >> /etc/ntopng/ntopng.confDann starten wir den Server neu mit dem Befehl

service ntopng restartWenn dann bei den Protokollen MyApp steht wurde alles richtig gemacht

Mehr Infos :

http://www.ntop.org/ndpi/configuring-ndpi-for-custom-protocol-detection/